OpenAI:董事会将拥有是否发布新AI大模型的决定权

OpenAI本周发布了一份长达27页的框架文件,制定了如何防范AI大模型“灾难性风险”的路线图。这些风险覆盖人工智能模型被用来制造大规模网络安全攻击、协助制造生化武器或核武器。

新治理框架对AI大模型的发布进行了制衡,OpenAI表示,公司领导层拥有是否发布新AI模型的决策权,但董事会拥有最终发布的决定权,以及“推翻OpenAI领导团队决定的权利”。

OpenAI还表示,即便董事会拥有否决部署有潜在风险的人工智能模型的权利,OpenAI仍然会事先通过安全检查来确保这些人工智能大模型的部署是安全的。

为此,OpenAI将会专门建立一个“准备”团队(preparedness team),由麻省理工学院(MIT)教授Aleksander Madry领导,以监控和减轻OpenAI人工智能模型的潜在风险。该团队将负责评估并密切监控AI模型的潜在风险,并将这些不同的风险进行评分,将风险分类为“低”、“中”、“高”或“严重”。

这一治理方案类似于欧盟刚刚达成协议的AI法案,较目前美国的监管更为严格。根据欧盟AI法案,将设置一系列可变动的监管标准,并对AI的风险进行分级,旨在对风险最高的人工智能系统施加最严格的限制,而针对其他风险程度较小的AI工具,则必须披露内容是由人工智能合成。

OpenAI的治理框架也指出:“只有在降低风险后评分为‘中’或以下的AI模型才能部署,并且只有在降低风险后得分为‘高’或以下的模型才能进一步开发。”

该公司表示,目前这份监管框架性的文件仍处于“测试版”阶段,预计将根据反馈定期更新。

自生成式AI聊天工具ChatGPT发布以来,科技行业在过去一年里一直在争论人工智能导致灾难的可能性。

今年早些时候,包括OpenAI的CEO奥尔特曼(Sam Altman)和谷歌Deepmind的CEO Demis Hassabis在内的数百名顶尖人工智能科学家和研究人员签署了一封简短的公开信表示,降低“人工智能的灭绝风险应该成为全球优先事项”。

该声明引起了公众的广泛警惕,尽管一些行业观察人士认为,人工智能还不足以产生即刻的危害。

OpenAI上个月出现戏剧性的动荡后,让外界更关注该公司对人工智能大模型的治理结构。OpenAI已经组建了新的“临时董事会”,引入包括新董事长、Salesforce联席CEO Bret Taylor、美国前财长Larry Summers等新董事,以确保最先进的人工智能技术能够造福人类。

不过临时董事会由于缺乏多样性受到广泛的批评,有人称人工智能成为了“富人游戏”;还有一些批评者担心,依靠公司的自我监管是不够的,立法者需要采取更多措施来确保人工智能工具的安全开发和部署。

已经有来自美国国会的议员提出,应设立一个类似于美国FDA的机构,监管人工智能服务的供应商,审核新系统的牌照,并制定各类标准。

目前美国的监管留给企业更大的余地,采取了“自愿行为准则”。拜登政府今年7月宣布了一项人工智能的自愿监管协议,并称包括亚马逊、Anthropic、谷歌、Inflection、Meta、微软和OpenAI等公司都已经同意对它们开发的AI系统进行自我监管。

美国企业的“自我监管”承诺包括对AI工具进行第三方安全测试,对偏见及隐私问题进行研究,并向政府和其他机构共享风险信息,开发能够应对气候变化等社会挑战的AI工具,以及包含识别人工智能生成素材的透明性措施工具。

斯坦福大学网络政策中心国际政策主任、欧盟委员会执行副主席维斯塔格的特别顾问Marietje Schaake在今年早些时候公开发表的一篇专栏文章中指出:“突然间,每个人都想规范人工智能,包括撰写公开信并讨论立法提案。但不幸的是,AI的特性与所提供的解决方案之间的不匹配,暴露了AI产品的开发者与政策制定者及立法者之间的鸿沟。”

她强调,立法者应该看到企业内部人工智能是如何运作的,此外,也不能忽视“人工智能不断变化的本质”,监管在严格执行的同时也要灵活变通。

上海交通大学行业研究院“人工智能 ”行业团队负责人史占中教授对第一财经记者表示,政策层面来讲,应该要加快AI相关领域的立法,特别在金融、安全、健康等领域严格监管,厘清AI的设计者、使用者、内容生成者的权责关系,完善AI决策的问责机制,保护大众合法权益;而从社会层面来讲,应加强AI技术的监管,推进AI研发者遵守伦理准则与规范AI的发展。

“低小散”问题仍存在,物流行业亟待多方面降本增效

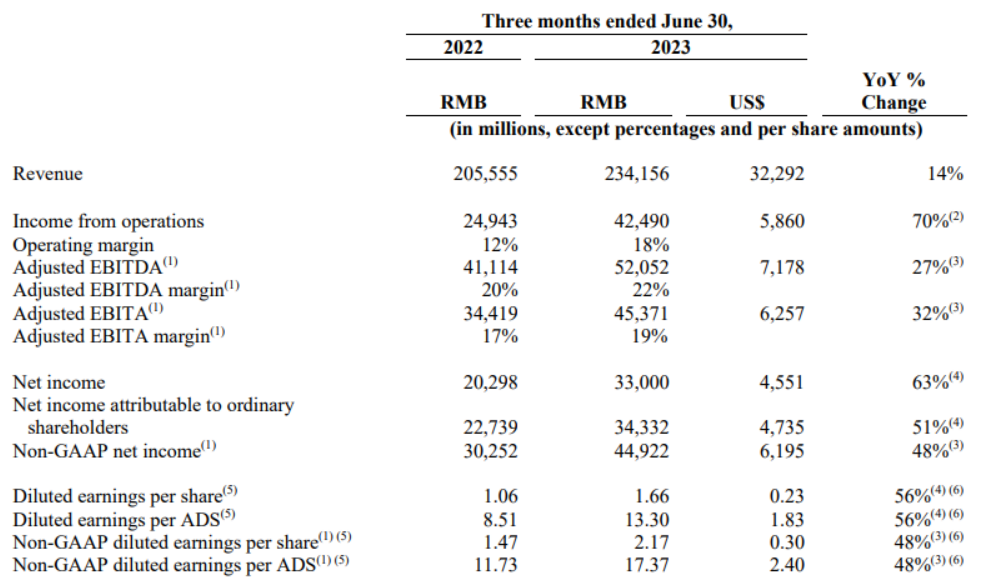

总结看,本次出台的文件聚焦于高质量发展,“还在沉迷价格战的,已经没有任何的前景了。”近日,中共中央办公厅、国务院办公厅印发了《有效降低全社会物流成本行动方案》(以下简称《方案》)。《方案》介绍,降低全社会物流成本是提高经济运行效率的重要举措,对构建高水平社会主义市场经济体制、加快构建新发展格局、推动高质量发展具有重要意义。为从全局和战略高度推动有效降低全社会物流成本,制定本方案。锤子财富2024-12-09 00:52:370000阿里巴巴2024财年第一季度财报:营收2341.6亿元,同比增长14%

阿里巴巴发布2024财年第一季度财报,这是组织变革后的首份季度业绩。财报显示,阿里巴巴2024财年第一财季营收2341.6亿元,同比增长14%。8月10日晚,阿里巴巴发布截至2023年6月30日的2024财年第一季度财报,这是组织变革后的首份季度业绩。锤子财富2023-08-10 19:32:450000文旅部发文恢复旅行社经营台湾居民入境团队旅游业务;存储芯片板块大涨丨早市热点

截至午盘,沪指涨0.13%,深成指涨0.51%,创业板指涨0.54%。5月19日,三大指数低开后震荡上行,截至午盘,沪指涨0.13%,深成指涨0.51%,创业板指涨0.54%。存储芯片、智能音箱、LED概念、中药板块涨幅居前,中船系、教育、传媒板块回调。一起回顾上午的市场热点。【存储芯片板块大涨】锤子财富2023-05-19 12:27:290000涉嫌违规披露重要信息案侦查所需,力源科技董事长被取保候审

力源科技公告,因个人原因,沈万中申请辞去公司总经理职务,辞去总经理职务后,沈万中仍在公司担任董事长职务。3月27日,力源科技公告,公司于2024年3月27日接到实际控制人、董事长沈万中的通知,上海市公安局于2024年3月26日出具《取保候审决定书》,因涉嫌违规披露重要信息案侦查所需,上海市公安局决定对公司实际控制人、董事长沈万中取保候审,期限从2024年3月26日起算。0000