迷人又危险,谁来为大模型设好“紧箍咒”?

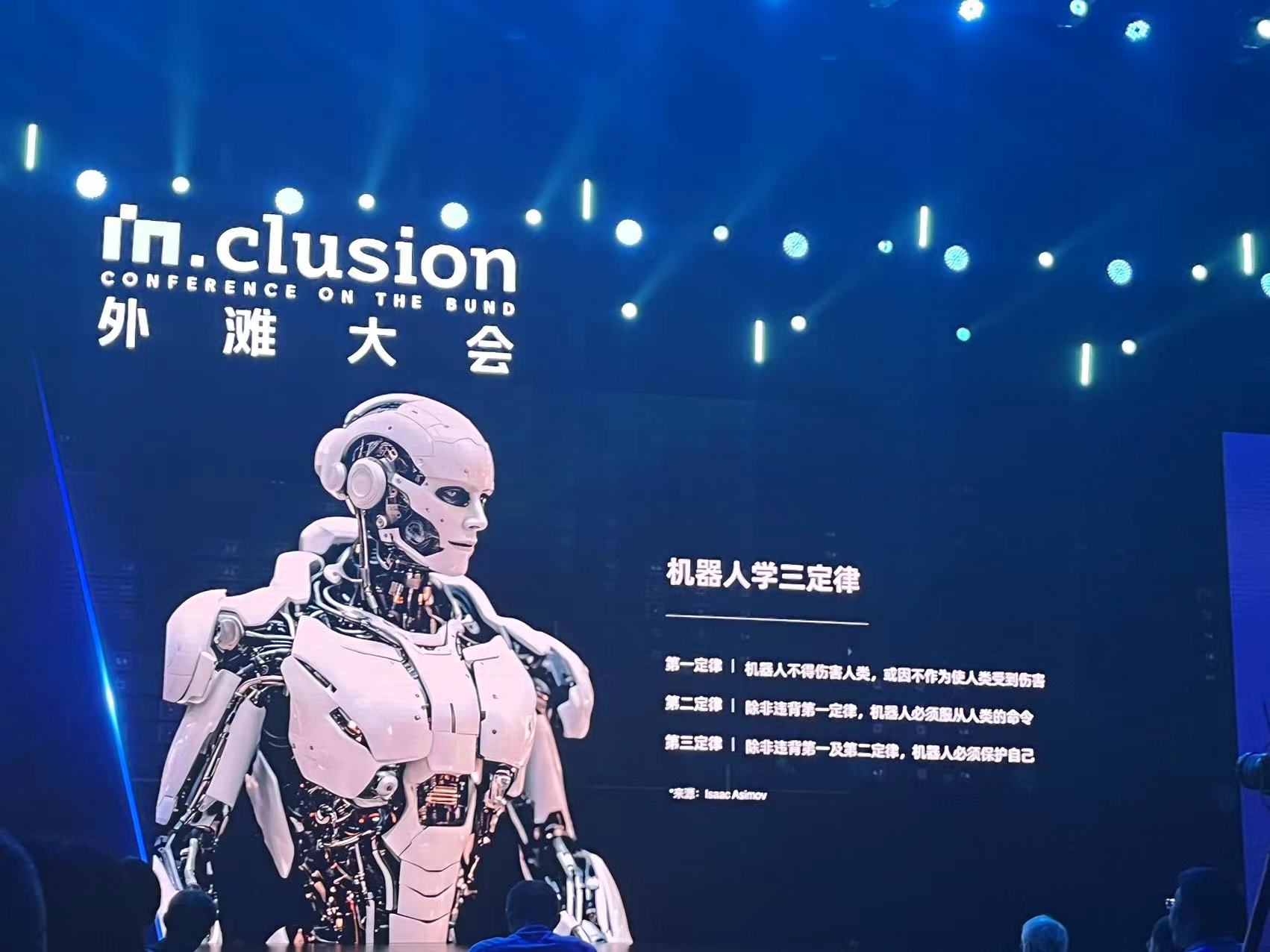

“随着以大模型为核心的AI技术快速发展,一些新的事件不断发生,我们做人工智能AI就好像生活在一个早期的黑暗丛林里面,到处都是风险,但是我们又不看清安全的全貌,只能逐步进行探索。”9月7日开幕的2023 INCLUSION·外滩大会上,中国科学院院士何积丰抛出了对大模型时代的安全问题的思考。

大模型进入我们的视野不到一年,但关于大模式时代的安全问题已经引发了不少忧虑。一个好的技术才刚刚走入我们的生活,为何就有如此多的安全问题?AI的安全问题和我们已知的互联网生产安全问题又有什么差别?何积丰认为,以大模型为核心的AI技术是人工智能发展中的一个拐点,大模型是真正像人的智能,有自主学习能力,进化速度非常快,经过多代迭代升级以后我们最终可能会有一个在多方面超过人类智能的超级智能。

在这样一个迷人又危险的大模型发展未来图景面前,人们不得不思考一个问题:一旦“奇点”到来,人类怎么去应对这超过我们的智能,我们是不是有能力来管理这个智能?

还有一个问题是,当大模型技术深入到社会生产生活的各个方面,用户对大模型越来越依赖和信任后,一旦大模型出现了问题,它的不精确或是错误部分也可能产生极大的影响。

机器学习泰斗,美国科学院、美国工程院院士迈克尔·乔丹也以AlphaFold预测蛋白质结果产生系统性偏差后可能带来的许多问题,指出了人类需要应对人工智能系统的“不确定性”。他表示,一个小的系统性偏差可能对研究结果带来极大的影响,但机器对它的预测是非常自信的,即便这个预测完全错误。

目前,大模型的发展有哪些安全问题需要重点关注?何积丰认为,主要是隐私和“对齐”的问题。隐私问题是指大模型可能在未经同意的情况下,收集、使用和泄露个人信息。大模型的训练过程中,可能涉及大量用户的个人信息和数据,在使用过程中,大模型也非常有能力嗅出用户的各种私密信息,这些信息有没有得到应有的保护,如何既保护用户隐私又不失去为用户服务的可能,是业界需要思考的问题。

同时,何积丰也提出了发展大模型“对齐”技术的重要性。他认为人类需要使大模型系统的目标和人类价值观一致,使其符合设计者的利益和预期,不会产生意外的有害后果。“如果把人工智能看作西游记里的孙悟空,那么对齐技术就像是唐僧口中的紧箍咒,可以保证孙悟空不任意使用他的能力去闯祸。”何积丰表示,对齐技术是控制人工智能安全的核心技术。

在实现“对齐”的技术途径中,何积丰重点介绍了反馈强化学习,主要通过人工反馈给模型不同的奖励信号,引导模型的高质量输出和事先给大模型提供明确的原则,系统自动训练模型对所有生成的输出结果提供初始排序两种方式进行。

在AI的安全讨论如火如荼进行的同时,何积丰同时强调,目前的AI安全工作还是集中在发现问题,还没有一个解决全部问题的答案。

尽管期待着对齐技术能够发挥“紧箍咒”般的魔力,但一个现实的问题是,对齐的基础建立在多元且动态变化的“人类价值观”上,而人类的价值与判定系统本身便充满了偏见和盲点,有非常多互相矛盾的地方和没有明确指出的潜在条件,这导致对齐成为一项令人眼花缭乱的跨学科研究。何积丰表示:“对齐不仅仅在考验我们的技术,也在审视我们的文化。”

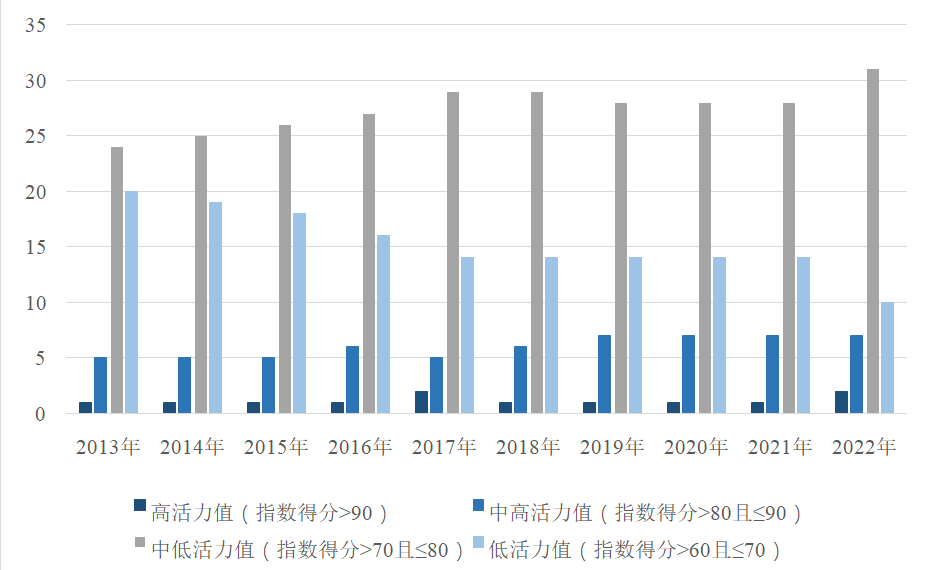

共建“一带一路”国家港口发展活力指数在沪发布

港口是构建“一带一路”立体互联互通网络的重要节点。这次指数的发布,选取50个中国企业已竣工移交或参与投资运营的港口项目。我国提出共建“一带一路”倡议10周年之际,“共建‘一带一路’国家港口发展活力指数”在沪发布。锤子财富2023-10-24 13:00:5600002023年我国数字经济核心产业增加值占GDP比重达到10%

数据要素市场日趋活跃,2023年数据生产总量达32.85ZB(1个ZB等于十万亿亿字节),同比增长22.44%。第七届数字中国建设峰会5月24日开幕。当天发布的《数字中国发展报告(2023年)》显示,2023年数字中国呈现良好发展态势。0000国家开发银行原党委委员、副行长周清玉接受中央纪委国家监委审查调查

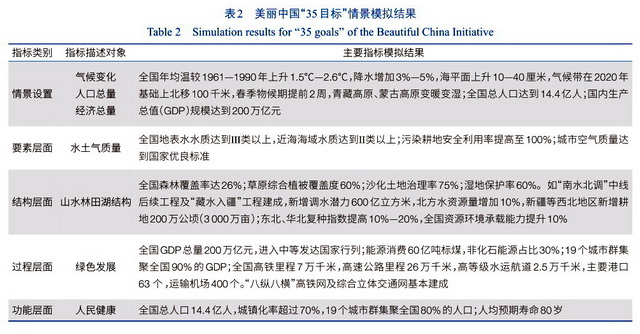

周清玉涉嫌严重违纪违法,目前正接受中央纪委国家监委纪律审查和监察调查。国家开发银行原党委委员、副行长周清玉涉嫌严重违纪违法,目前正接受中央纪委国家监委纪律审查和监察调查。0000美丽中国专项:2035年全国城市空气质量达到国家优良标准

现实状况与目标愿景尚存在明显差距,而这“正是未来美丽中国建设中需要逐步解决的问题。近年来,“科技助力美丽中国建设”已得到各方重视。“未来30年中华大地上的自然景观、生活环境和人地关系将发生历史性变化,展现出一幅新的自然人文景象。”这是中国科学院近期完成的美丽中国“35目标”和“50愿景”情景模拟给出的结论。锤子财富2024-01-25 10:08:160000夜经济的风吹回“油尖旺”,香港发力重振夜经济

短期内,港府要与业界合力把香港夜市搞活搞旺。淄博烧烤、长沙夜市、深圳“小港夜”……今年以来,“夜经济”成为不少城市“出圈”,变城市流量为“留量”的关键。美团数据显示,暑期以来,“夜游”“夜市”搜索量较去年同期增长约80%,攻略笔记同比增长160%;OTA平台暑期夜游产品销量较2019年增近7倍,城市新“夜”态已形成。锤子财富2023-09-12 21:12:380000