大模型书生·浦语再开源,推出200亿参数版本

9月20日,上海人工智能实验室宣布与商汤科技联合香港中文大学和复旦大学正式推出书生·浦语大模型(InternLM)200亿参数版本InternLM-20B,并在阿里云魔搭社区(ModelScope)开源首发。同时,书生·浦语面向大模型研发与应用的全链条工具链升级,与InternLM-20B一同继续全面开放,向企业和开发者提供免费商用授权。

上海人工智能实验室是人工智能领域的新型科研机构,主要开展战略性、原创性、前瞻性的科学研究与技术攻关。在大模型的应用价值日趋受到关注的背景下,上海人工智能实验室联合多家机构推出中量级参数的 InternLM-20B 大模型,其重点在于性能先进且应用便捷,以不足三分之一的参数量,达到了当前被视为开源模型标杆的Llama2-70B的能力水平。

自今年6月首次发布以来,书生·浦语已历多轮升级,此次其发布的20B量级模型具备更为强大的综合能力,在复杂推理和反思能力上尤为突出,因此可为实际应用带来更有力的性能支持;同时,20B量级模型可在单卡上进行推理,经过低比特量化后,可运行在单块消费级GPU上,因而在实际应用中更为便捷。

在相对有限的参数规模下,研究人员在架构设计时面临重要的取舍——提高模型的深度还是宽度?通过广泛的对照实验,书生·浦语团队发现,更深的模型层数更有利于复杂推理能力的培养。因此在架构设计时,研究人员把模型层数设定为60层,而7B与13B模型通常采用32层或者40层设计;同时内部维度保持在5120,处于适中水平。通过架构设计上的新取舍,InternLM-20B在较高计算效率的条件下实现了复杂推理能力的显著提升。

相比于此前的开源模型,InternLM-20B的能力优势主要体现在更长的语境。通过外推技术,InternLM-20B支持16K语境长度,可以支持长文理解、长文生成和超长对话。

工具调用是拓展大语言模型能力边界的重要手段,也是OpenAI近期推出大模型的重点特性之一。InternLM-20B对话模型支持了日期、天气、旅行、体育等数十个方向的内容输出及上万个不同的 API。

龙年上海金融开放再迈步,联博基金、东方汇理金融科技、开德私募同日开业

中国的资管生态系统日臻完善,高质量和可持续发展则是下一阶段的目标。龙年伊始,上海又迎来三家外资金融巨头开业。2月26日,联博基金管理有限公司、东方汇理金融科技(上海)有限公司、开德私募基金管理(上海)有限公司三家外资金融机构在沪举行集体开业仪式。上海市副市长解冬出席开业仪式并致辞。锤子财富2024-02-26 23:58:290000央行:4月份沪市日均交易量环比增加23.9%

4月份,债券市场共发行各类债券62153.6亿元。5月23日,央行公布2023年4月份金融市场运行情况。4月份,沪市日均交易量为4944.2亿元,环比增加23.9%;深市日均交易量为6468.8亿元,环比增加21.8%。一、债券市场发行情况0000抖音禁止公益类账号变现:不得进行直播打赏、电商销售

新规明确要求,“公益类账号,不得进行直播打赏、电商销售等营利性行为”。6月1日,据抖音和ta的朋友们微信公众号消息,极个别创作者利用互联网平台,试图以“助农”“助困”“助残”为由,通过编造不实“贫困生活”“破旧住房”等场景,实施虚假“捐赠救助”等“公益”行为,骗取流量、钱财和爱心,影响恶劣。锤子财富2023-06-02 14:33:220000严监管风暴来袭,年内63股因信披违规遭立案调查

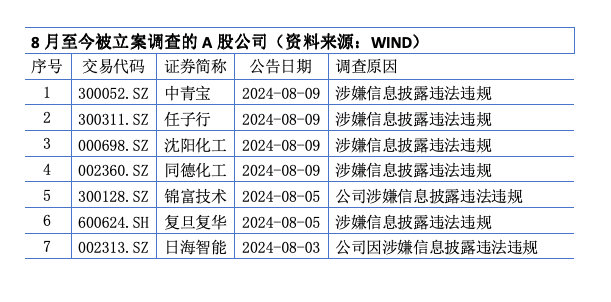

较去年同期数量增加超五成多家公司同日被立案调查,严监管风暴再度席卷上市公司。上周五(8月9日)晚间,中青宝等4家公司公告被立案,均涉嫌信披违规。受此消息影响,本周一(8月12日),上述4股股价重挫,任子行收跌19.9%,中青宝跌逾16%,同德化工、沈阳化工跌逾9%。Wind数据显示,本月至今已有7家A股公司被立案调查。而截至8月9日,年内已有63家A股公司被立案,较去年同期数量增加超五成。锤子财富2024-08-13 12:10:470000一季度上海大宗不动产交易16宗,酒店类资产较受关注

2023年全年,上海酒店总交易额达93.2亿。在上海大宗交易市场上,投资者对酒店类资产的热情正在提高。2023年,上海酒店投资交易市场上发生了多笔引得市场瞩目的交易,例如金峰水泥斥资超24亿买下上海市静安区的奢华型酒店宝格丽酒店,万达集团将自持的上海万达瑞华酒店出售给新加坡金鹰集团,绿地集团将上海绿地万豪酒店出售给北京银行等。图片摄影:任玉明锤子财富2024-04-11 10:06:280000